Hi guys! Gumawa ako ng 100-item Engineering Board Exam Questions for Mathematics na pwede nyong sagutan good for 4 hours as preboard exam na rin to test kung papasa kayo sa Math. 70 passing score.

Narito ang links ng videos ko for Engineering Board Exam Reviewers kung saan makikita nyo rin ang solutions sa exam. Please like and follow nyo na rin ang fb page natin na enginerdmath for more study and review materials. Good luck amd God bless future engineers!

ENGINEERING BOARD EXAM REVIEWERS PLAYLISTS

https://youtu.be/Nx_4YOMuujw. - Algebra 1 Part 1

https://youtu.be/R5exSdU2uUM. -Algebra 1 Part 2

https://youtu.be/Ewd-z5tMwy8 -Algebra 2 Part 1

https://youtu.be/eO55JUAu9Bo -Algebra 2 Part 2

https://youtu.be/InsL-W28JT8. -Algebra 3 Part 1

https://youtu.be/SDpuPhb_pkk. - Algebra 3 Part 2

https://youtu.be/61S0IXeTmZE. - Algebra 4 Part 1

https://youtu.be/eXRtnHXh_70. - Algebra 4 Part 2

https://youtu.be/zvHpjiCwMxQ -Math Refresher Part 1

https://youtu.be/RsT6Gs45eMw - Calculus Part 1

https://youtu.be/x1A0WM9kKoQ - Probability and Statistics

https://youtu.be/dp5XWvNzsPQ - Math Refresher Part 2

https://youtu.be/gT1ipIaAs9k - Trigonometry Part 1

https://youtu.be/KJyrN8GorRk - Calculus Part 2

https://youtu.be/sb9h2TEbI2w- Plane and Solid Geometry Part 1

https://youtu.be/WYQf8uX1nNc- Differential Equations Part 1

https://youtu.be/J0fUHPSknzg- Math Refresher Part 3

https://www.youtube.com/channel/UCckZq2Y0Bfpha4D0CGG4W1g -Math Refresher Part 4

https://youtu.be/PovJJM71iUo - Calculator Techniques Part 1 (Algebra 1)

https://youtu.be/4EMV1ofGGZ4 - Calculator Techniques Part 2 (Algebra 2)

https://youtu.be/r4TUrT5LXG8 - Calculator Techniques Part 3 (Algebraic Equations)

https://youtu.be/Gpss4krXMT0 - Calculator Techniques Part 4 (First and Partial Derivatives)

https://youtu.be/ff4OmcVTQDc -Calculator Techniques Part 5 (Second Derivatives)

https://youtu.be/sMpp0p7meqo - Calculator Techniques Part 6 (Third Derivatives)

https://youtu.be/26z-t9NoErA -Calculator Techniques Part 7(Implicit Differentiation)

https://youtu.be/iLYaM_PS7H0 -Calculator Techniques Part 8 (Indefinite Integral)

https://youtu.be/CiheSw0ZLjk -Calculator Techniques Part 9 (Definite Integral)

https://youtu.be/eefcan5aq_U -Calculator Techniques Part 10( Differential Equations)

https://youtu.be/4l3MDRXiFEA -Calculator Techniques Part 11 (Solving First Order DE)

https://youtu.be/V8TbMh9Mp1g -Calculator Techniques Part 12(Solving Higher Order DE)

https://youtu.be/f-GnZD_Lj6s -Calculator Techniques Part 13(Areas Bounded by Curves)

https://youtu.be/pfdXMYXFhK0 -Calculator Techniques Part 14(Sequences and Series)

https://youtu.be/08ANEVyQsjg -Calculator Techniques Part 15(Arithmetic Sequence)

https://youtu.be/NdRqWWzITwA -Calculator Techniques Part 16 (Geometric Sequence)

https://youtu.be/_H0dJg6vTB8 -Calculator Techniques Part 17 (Laplace Transform)

https://youtu.be/fXOLQzRKygY -Calculator Techniques Part 18 (Inverse Laplace Transform)

https://youtu.be/xVerHU40KQc -Calculator Techniques Part 19 (Complex Numbers 1)

https://youtu.be/njvh56nXEPY -Calculator Techniques Part 20 (Complex Numbers 2)

https://youtu.be/iqWJL7dFIEM -Calculator Techniques Part 21 (Matrices)

https://youtu.be/oWQ6bhZRSTE -Calculator Techniques Part 22 (4X4 Determinants)

https://youtu.be/WtVBWNerxQA -Calculator Techniques Part 23 (5x5 Determinants)

https://youtu.be/sPwLNV4Rmi8 -Calculator Techniques Part 24 (Clock Problems)

https://youtu.be/e7CypitoYk4 -Calculator Techniques Part 25 (Angle Conversion)

https://youtu.be/-d0rMaWSQ-E -Calculator Techniques Part 26 (Trigo Identities/Equations)

https://youtu.be/5-bJ_xzJk4Y -Calculator Techniques Part 27 (Sine and Cosine Law)

https://youtu.be/sMpwjXzlOr0 -Calculator Techniques Part 28 (Functions)

https://youtu.be/qYmUhx6GJyA -Calculator Techniques Part 29 (Limits of Functions)

https://youtu.be/VTqujrqTPS4 -Calculator Techniques Part 30 (Maxima/Minima)

https://youtu.be/sGiPadRDFZQ -Math Refresher Part 6

https://youtu.be/7m_TUmavINQ -Math Refresher Part 7

https://youtu.be/di1yalzXwbI -Math Refresher Part 8

https://youtu.be/AeW8Iwsf0ag -Math Refresher Part 9

https://youtu.be/lz-JbXrbJmk -Math Refresher Part 10

https://youtu.be/Ocwpuz51Ojk -Math Refresher LS Part 1

https://youtu.be/IwDhCcDUlfc -Math Refresher LS Part 2

https://youtu.be/Kz-dKF7lMx8 -Math Refresher LS Part 3

https://youtu.be/NNzJ-haLQ_Q -Math Refresher LS Part 4

https://youtu.be/y5KlEMj-Zc8 -Math Refresher LS Part 5

https://youtu.be/gi_j-VTgPp0 -Math Refresher LS Part 6

https://youtu.be/wNIhm3sjPHg -Math Refresher LS Part 7

https://youtu.be/zF7AWXYEqGg -Math Refresher LS Part 8

https://youtu.be/IJEIdecST7k -Math Refresher LS Part 9

https://youtu.be/5O-8LREBk40 -Math Refresher LS Part 10

https://youtu.be/VBSfZm4HipI -Math Refresher LS Part 11

https://youtu.be/js2-MIyPuwM -Math Refresher LS Part 12

https://youtu.be/FvDcMKHbOfQ -Math Refresher LS Part 13

https://youtu.be/oWiVspDs300 -Math Refresher LS Part 14

https://youtu.be/M6OAN_qJ4GA -Math Refresher LS Part 15

https://youtu.be/DWrMOP1Qb8Y -Math Refresher LS Part 16

https://youtu.be/JzY77wYE8-4 -Math Refresher LS Part 17

GENERAL ENGINEERING &APPLIED SCIENCE (GEAS/ESAS)

https://youtu.be/GHsSVfiaFu8 -Chemistry Part 1

https://youtu.be/sHeg_DK2hZ8 -Chemistry Part 2

https://youtu.be/EGjgUVrgBuU -Physics Part 1

https://youtu.be/zmRIMRzm4tA -Physics Part 2

https://youtu.be/l_BnbXfaPek -Engineering Mechanics Statics

https://youtu.be/TK8gDBpv9EY -Engineering Mechanics Dynamics

https://youtu.be/CkAp0jAEIa4 - General Engineering And Applied Science (GEAS/ESAS) Refresher Part 1

https://youtu.be/190hsMzoLUE - General Engineering And Applied Science (GEAS/ESAS) Refresher Part 2

ELECTRONICS REVIEWERS PLAYLIST

ELECTRONIC SYSTEMS & TECHNOLOGY (EST)

Please support me on YT by joining and get these perks:

BENEFITS:

~You'll get a top fan badge on your name when you comment on my video.

~You'll have exclusive access to more supplemental math, science and engineering videos like reviewers, solved exam, etc. i personally make for Board Exam, CETs, CSE

~You'll have exclusive access to community post about math, science and engineering reviewers, notes, problem sets, in pdf forms, etc. i personally make which updates every week as good guide with your studies to pass your exams and subjects

~You’ll help me keep on making educational contents for free education in our country through my online videos

PDF file download link:

Aside from this, you can also have access to may other math science and engineering notes which updates every week.

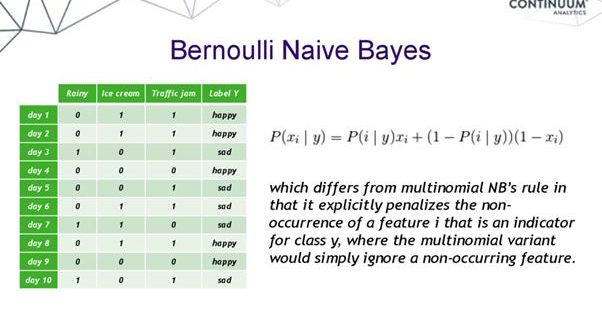

là tuyến tính. Công thức cơ bản của mô hình như sau:

là tuyến tính. Công thức cơ bản của mô hình như sau:

Ví dụ: (Trong ảnh luôn nha)

Ví dụ: (Trong ảnh luôn nha)

Chia sẻ bên dưới nhé!

Chia sẻ bên dưới nhé!